| Line 8: | Line 8: | ||

| − | '''模式识别''' | + | '''模式识别''' 的目标是将新观察的特征向量进行分类。为了进行分类的决定,需要通过某种'''判决规则(decision rule)'''。在 '''统计学模式识别''' 一般假设特征向量是个随机变量“X”,又有个概率密度函数或者概率质量函数,并且此函数依赖其分类。如下假设有两个类型:(<span class="texhtml">ω<sub>0</sub>,ω<sub>1</sub></span>), 以便写公式也不会失去一般性。因此X的概率密度或质量函数是<span class="texhtml">''P''(''X'' | ω<sub>''i''</sub>)</span> (如下称pdf)。每个类型的'''先验概率'''写成<span class="texhtml">''P''(ω<sub>''i''</sub>)</span>。 |

| − | 统计学的主要部分之一是'''假设检验''' | + | 统计学的主要部分之一是'''假设检验'''。下面描述假设检验在统计学模式识别的验证。 |

== 贝叶斯(Bayes)判决规则 == | == 贝叶斯(Bayes)判决规则 == | ||

| − | 将<span class="texhtml">''g''<sub>''i''</sub>(''X'')</span> 是<span class="texhtml">ω<sub>''i''</sub></span>的'''后验概率(posterior probability)'''。选<span class="texhtml">ω<sub>1</sub></span>或<span class="texhtml">ω<sub>2</sub></span>的判决规则为: 如果<span class="texhtml">''g''<sub>0</sub>(''X'') > ''g''<sub>1</sub>(''X'')</span>,就选<span class="texhtml">ω<sub>0</sub></span>, 不然选<span class="texhtml">ω<sub>1</sub></span>。据贝斯定理, 判决规则能以 ''' | + | 将<span class="texhtml">''g''<sub>''i''</sub>(''X'')</span> 是<span class="texhtml">ω<sub>''i''</sub></span>的'''后验概率(posterior probability)'''。选<span class="texhtml">ω<sub>1</sub></span>或<span class="texhtml">ω<sub>2</sub></span>的判决规则为: 如果<span class="texhtml">''g''<sub>0</sub>(''X'') > ''g''<sub>1</sub>(''X'')</span>,就选<span class="texhtml">ω<sub>0</sub></span>, 不然选<span class="texhtml">ω<sub>1</sub></span>。据贝斯定理, 判决规则能以 '''概率比(likelihood ratio)'''表示: |

<math>\begin{align} | <math>\begin{align} | ||

| Line 25: | Line 25: | ||

</math> | </math> | ||

| − | k | + | k 是一个常数。贝叶斯(Bayes)判决规则就说明可以通过概率比与常数的比较进行决定,叫做'''概率比检测(likelihood ratio test)'''。 |

== 贝叶斯错误 == | == 贝叶斯错误 == | ||

| Line 48: | Line 48: | ||

如果你曾经上过入门的统计学课,你大概能想起传统的 '''假设检验'''. 如下为例子: <br> | 如果你曾经上过入门的统计学课,你大概能想起传统的 '''假设检验'''. 如下为例子: <br> | ||

| − | <blockquote> | + | <blockquote>一位人类学研究者争对一个太平岛的部落,认为此部落预期寿命比一般人长。把 <span class="texhtml">μ</span> 定义为此部落预期寿命。全世界人口的预期寿命是67.2年。为了检验他的假设,他从公开记录中随机选出了100个讣告作为样本,发现样本平均预期寿命是72,标准差是15。把 X̄ 定义为样本平均值, S为样本标准差,两个都是来自随机样本,两个都是随机变量。然后用如下的假设检验: |

<br> | <br> | ||

零假设 (H0): <span class="texhtml">μ − 67.2 = 0</span> | 零假设 (H0): <span class="texhtml">μ − 67.2 = 0</span> | ||

| Line 58: | Line 58: | ||

决策规则: 若 <math> T < Z_{\alpha} </math> | 决策规则: 若 <math> T < Z_{\alpha} </math> | ||

| − | + | 选H0否则选H1. </blockquote> | |

| − | 如上的H0、H1 、与α是传统的记法。α是 P( | + | 如上的H0、H1 、与α是传统的记法。α是 P(此判决规则选H1 | H0正确)的上限。在这种检验,”H0正确但选H1“的错误叫做第一型错误,”H1正确但选H0“叫做第二型错误。所以 P(此判决规则选H1 | H0正确)= P(第一型错误)。 |

| − | + | ''这种假设检验最重要的特点是决定规则的目标是控制P(第一型错误)在α下。'' 假如α=.05。 | |

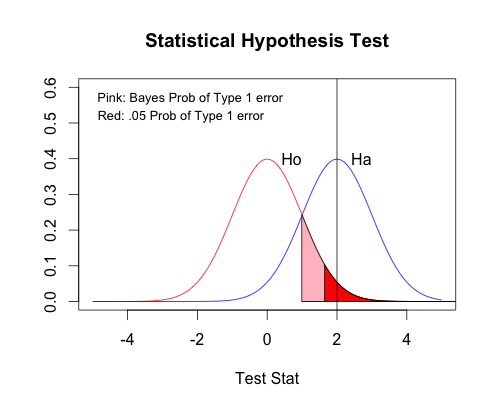

从统计学模式识别的角度上看此假设检验,H0 和 H1是两种类别 -- 可以换回原来的 “ω” 记法。随机特征向量是 T,而且条件pdf是高斯分布(标准正常密度分布)。研究者从T抽一次抽样值 t=(72 - 67.2)/(15 * 15 / 100) = 2。 各类的先验概率是平等的。如下图片显示两类的pdf。 | 从统计学模式识别的角度上看此假设检验,H0 和 H1是两种类别 -- 可以换回原来的 “ω” 记法。随机特征向量是 T,而且条件pdf是高斯分布(标准正常密度分布)。研究者从T抽一次抽样值 t=(72 - 67.2)/(15 * 15 / 100) = 2。 各类的先验概率是平等的。如下图片显示两类的pdf。 | ||

| Line 68: | Line 68: | ||

'''[[Image:Rplot.png]]''' | '''[[Image:Rplot.png]]''' | ||

| − | + | 粉红色的领域是在贝斯决定规则下(平等先验概率)第一型错误的概率。红色的领域是固定在.05以下第一型错误的领域 -- 在标准正常分布高于1 - .05分位点 = 高于1.644。贝斯的领域同时依赖<math> \omega_0 </math> 跟<math> \omega_1 </math>的分布 -- 具体说它依赖<math> \omega_0 </math>密度函数减<math> \omega_1 </math>密度函数的根。但是如果只想控制第一型错误,只需要看<math> \omega_0 </math>分布。在这个检验,2 > 1.644, 决定规则让选H1.研究者大概要在他的论文宣告P值(显著性概率)为P(T>2| <math> \omega_0 </math> 正确)= 0.022,也就在是Ho的分布下2以上的曲线下面积。 | |

| − | + | 这种检验的决定规则控制第一型错误的概率是为了避免在脆弱的证据下报告肯定的研究成果。它用如下的段落: | |

*首先将P(第一型错误)=ε<sub>0</sub> 固定在一定的数量α。 | *首先将P(第一型错误)=ε<sub>0</sub> 固定在一定的数量α。 | ||

| − | *然后将P(第二型错误)=ε<sub>1</sub> | + | *然后将P(第二型错误)=ε<sub>1</sub>控制在尽可能少的数量下。满足此条件的决定规则在统计学中叫做“一致最大功效检验(UMP test)”。 |

Neyman-Pearson引理:决定规则当UMP test的充分必要条件如下: | Neyman-Pearson引理:决定规则当UMP test的充分必要条件如下: | ||

| Line 87: | Line 87: | ||

==结论== | ==结论== | ||

| − | + | 传统的统计学假设检验的目标是将一个类别的错误概率固定在一定的水平下,然后尽可能减少另一个列别的错误概率。统计学假设检验认为一种错误要比另一种严重,但是贝叶斯决定规则给两种错误平等待遇。Neyman-Pearson 引理说明进行概率比检测是满足统计学假设检验目标的充分必要条件。不过贝叶斯决定规则毕竟是概率比检测,所以贝叶斯决定规则的结果是固定一个类别的错误概率在一定的水平下,然后尽可能减少另一个列别的错误概率。 | |

== References == | == References == | ||

Revision as of 01:02, 3 May 2014

Neyman-Pearson: How Bayes Decision Rule Controls Error

A slecture by Robert Ness

Partly based on the ECE662 Spring 2014 lecture material of Prof. Mireille Boutin.

模式识别 的目标是将新观察的特征向量进行分类。为了进行分类的决定,需要通过某种判决规则(decision rule)。在 统计学模式识别 一般假设特征向量是个随机变量“X”,又有个概率密度函数或者概率质量函数,并且此函数依赖其分类。如下假设有两个类型:(ω0,ω1), 以便写公式也不会失去一般性。因此X的概率密度或质量函数是P(X | ωi) (如下称pdf)。每个类型的先验概率写成P(ωi)。

统计学的主要部分之一是假设检验。下面描述假设检验在统计学模式识别的验证。

贝叶斯(Bayes)判决规则

将gi(X) 是ωi的后验概率(posterior probability)。选ω1或ω2的判决规则为: 如果g0(X) > g1(X),就选ω0, 不然选ω1。据贝斯定理, 判决规则能以 概率比(likelihood ratio)表示:

$ \begin{align} & g_0(X) > g_1(X) \\ \Rightarrow & P(\omega_0|X) > P(\omega_1|X) \\ \Rightarrow & \frac{P(X|\omega_0)P(\omega_0)}{P(X)} > \frac{P(X|\omega_1)P(\omega_1)}{P(X)} \\ \Rightarrow & P(X|\omega_0)P(\omega_0) > P(X|\omega_1)P(\omega_1) \\ \Rightarrow & l(X)=\frac{P(X|\omega_0)}{P(X|\omega_1)} > \frac{P(\omega_1)}{P(\omega_0)} = k \end{align} $

k 是一个常数。贝叶斯(Bayes)判决规则就说明可以通过概率比与常数的比较进行决定,叫做概率比检测(likelihood ratio test)。

贝叶斯错误

为了评估判决规则的效果,需要计算错误的概率。计算需要如下的记法定义:

- $ \epsilon_0 $ = P(错误选ω1 | ω0正确),$ \epsilon_1 $ = P(错误选ω0 | ω1正确)

- Ri是选ωi的领域:

$ R_i=\{x\in X | choose \ \omega_i\} $

- r(X)= min(g0(X),g1(X))。

在贝叶斯决定规则下,错误几率等于贝叶斯错误几率(Bayes error rate):

$ \begin{align} \\ \epsilon_{Bayes} & = E(r(X)) = \int min(P(\omega_0)P(X|\omega_0), P(\omega_1)P(X|\omega1))dX \\ &= P(\omega_0) \int_{R_1}P(X|\omega_0)dX + P(\omega_1) \int_{R_0} P(X|\omega_1)dX \\ &= P(\omega_0)\epsilon_0 + P(\omega_1)\epsilon_1 \end{align} $

统计学假设检验的决定规则

如果你曾经上过入门的统计学课,你大概能想起传统的 假设检验. 如下为例子:

一位人类学研究者争对一个太平岛的部落,认为此部落预期寿命比一般人长。把 μ 定义为此部落预期寿命。全世界人口的预期寿命是67.2年。为了检验他的假设,他从公开记录中随机选出了100个讣告作为样本,发现样本平均预期寿命是72,标准差是15。把 X̄ 定义为样本平均值, S为样本标准差,两个都是来自随机样本,两个都是随机变量。然后用如下的假设检验:选H0否则选H1.

零假设 (H0): μ − 67.2 = 0

对立假设(H1): μ − 67.2 > 0

检验统计量: $ T = \frac{\bar{X} - 67.5}{\sqrt{S^{2}/N}} \sim N(0,1) $.

决策规则: 若 $ T < Z_{\alpha} $

如上的H0、H1 、与α是传统的记法。α是 P(此判决规则选H1 | H0正确)的上限。在这种检验,”H0正确但选H1“的错误叫做第一型错误,”H1正确但选H0“叫做第二型错误。所以 P(此判决规则选H1 | H0正确)= P(第一型错误)。

这种假设检验最重要的特点是决定规则的目标是控制P(第一型错误)在α下。 假如α=.05。

从统计学模式识别的角度上看此假设检验,H0 和 H1是两种类别 -- 可以换回原来的 “ω” 记法。随机特征向量是 T,而且条件pdf是高斯分布(标准正常密度分布)。研究者从T抽一次抽样值 t=(72 - 67.2)/(15 * 15 / 100) = 2。 各类的先验概率是平等的。如下图片显示两类的pdf。

粉红色的领域是在贝斯决定规则下(平等先验概率)第一型错误的概率。红色的领域是固定在.05以下第一型错误的领域 -- 在标准正常分布高于1 - .05分位点 = 高于1.644。贝斯的领域同时依赖$ \omega_0 $ 跟$ \omega_1 $的分布 -- 具体说它依赖$ \omega_0 $密度函数减$ \omega_1 $密度函数的根。但是如果只想控制第一型错误,只需要看$ \omega_0 $分布。在这个检验,2 > 1.644, 决定规则让选H1.研究者大概要在他的论文宣告P值(显著性概率)为P(T>2| $ \omega_0 $ 正确)= 0.022,也就在是Ho的分布下2以上的曲线下面积。

这种检验的决定规则控制第一型错误的概率是为了避免在脆弱的证据下报告肯定的研究成果。它用如下的段落:

- 首先将P(第一型错误)=ε0 固定在一定的数量α。

- 然后将P(第二型错误)=ε1控制在尽可能少的数量下。满足此条件的决定规则在统计学中叫做“一致最大功效检验(UMP test)”。

Neyman-Pearson引理:决定规则当UMP test的充分必要条件如下:

- ε0被固定在一位常数α然后决定规则是

- 如果

$ l(T)=\frac{P(T| \omega_0 )}{P(T| \omega_1)} > k $

决定选$ \omega_0 $

- 如果

$ l(T)=\frac{P(T| \omega_0 )}{P(T|\omega_1 )} < k $

决定选$ \omega_1 $。

结论

传统的统计学假设检验的目标是将一个类别的错误概率固定在一定的水平下,然后尽可能减少另一个列别的错误概率。统计学假设检验认为一种错误要比另一种严重,但是贝叶斯决定规则给两种错误平等待遇。Neyman-Pearson 引理说明进行概率比检测是满足统计学假设检验目标的充分必要条件。不过贝叶斯决定规则毕竟是概率比检测,所以贝叶斯决定规则的结果是固定一个类别的错误概率在一定的水平下,然后尽可能减少另一个列别的错误概率。

References

- Mireille Boutin, "ECE662: Statistical Pattern Recognition and Decision Making Processes," Purdue University, Spring 2014.

- Casella, George, and Roger L. Berger. Statistical inference. Vol. 70. Belmont, CA: Duxbury Press, 1990.

- Fukunaga, Keinosuke. Introduction to statistical pattern recognition. Academic press, 1990.

Questions and comments

If you have any questions, comments, etc. please post them On this page.